在当今数据驱动的时代,企业面临着海量、高速、多样化的数据洪流。如何实时、高效地处理这些流式数据,从中提取价值,成为了核心挑战。Apache Kafka,作为一个分布式流处理平台,凭借其高吞吐、可扩展、持久化的特性,已成为构建实时数据管道和流式应用的事实标准。本文将为您提供一份Kafka实战指引,助您驾驭实时海量流式数据处理。

一、理解Kafka的核心架构

Kafka的设计围绕几个核心概念展开,理解它们是实战的第一步。

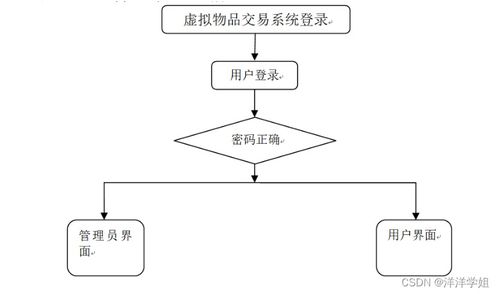

- 生产者(Producer)与消费者(Consumer):生产者将数据发布到Kafka的特定主题(Topic);消费者则从主题订阅并拉取数据进行处理。这种解耦模式是实现异步、灵活数据处理的基础。

- 主题(Topic)与分区(Partition):主题是数据发布的类别或订阅源名称。一个主题可以被分为多个分区,分区是Kafka实现水平扩展和并行处理的基本单元。数据被追加写入分区,并分配一个唯一的偏移量(Offset)。

- 代理(Broker)与集群(Cluster):一个Kafka服务器称为Broker。多个Broker组成一个集群,共同提供高可用性和负载均衡服务。每个分区会在多个Broker上存储副本(Replica),确保数据安全。

- ZooKeeper的协调作用:在较新版本中(Kafka 2.8+开始支持KRaft模式以摆脱ZooKeeper),ZooKeeper通常用于管理集群元数据、领导者选举和配置信息,是集群稳定运行的“大脑”。

二、构建高吞吐数据管道:实战配置要点

要让Kafka处理海量数据,合理的配置和架构设计至关重要。

- 生产者端优化:

- 批量发送(Batch):配置

batch.size和linger.ms参数,让生产者在发送前积累小批消息,减少网络请求次数,大幅提升吞吐量。

- 压缩(Compression):启用消息压缩(如snappy, lz4, gzip),可以有效减少网络传输和磁盘存储的开销。

- 确认机制(Acks):根据业务对数据可靠性的要求,选择

acks=0(最高吞吐,无确认)、acks=1(领导者确认,平衡)或acks=all(所有副本确认,最可靠)。

- 消费者端优化:

- 消费者组(Consumer Group):利用消费者组实现负载均衡和并行消费。组内每个消费者负责消费一个或多个分区,分区数是消费者并行度的上限。

- 偏移量提交:理解自动提交与手动提交的优劣。对于精确一次性处理(Exactly-Once)场景,需仔细管理偏移量提交与业务处理的原子性。

- 拉取参数:调整

fetch.min.bytes和fetch.max.wait.ms,可以在延迟和吞吐量之间取得平衡。

- Broker与主题规划:

- 分区数规划:分区数决定了主题的最大并行度。需根据目标吞吐量和消费者数量预估,并预留扩展空间,但分区并非越多越好,过多会影响可用性和延迟。

- 副本因子(Replication Factor):通常设置为3,以确保在单个节点甚至机架故障时数据不丢失、服务不中断。

- 日志保留策略:根据数据价值设置

retention.ms(时间)或retention.bytes(大小),控制磁盘空间占用。

三、进阶:使用Kafka Streams与KSQL进行流式数据处理

Kafka不仅是消息队列,其内置的流处理库Kafka Streams和KSQL(现为kafkaDB中的ksqlDB)让实时数据处理变得更为强大和便捷。

- Kafka Streams:一个用于构建实时流处理应用的Java库。它直接集成在应用中,无需单独的处理集群。您可以轻松实现:

- 数据转换(Map/Filter):对流中的每条记录进行清洗或变形。

- 聚合(Aggregation):基于时间窗口或会话窗口进行计数、求和、求平均等操作。

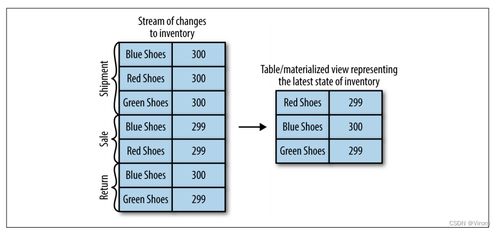

- 连接(Join):将两个流(或流与表)基于键进行关联,如同在数据库中进行表连接。

- ksqlDB:为Kafka提供的流式SQL引擎。您可以使用熟悉的SQL语句来定义流(Stream)和表(Table),并执行持续的查询,极大降低了实时应用开发门槛。例如,

CREATE STREAM pageviews WITH (KAFKA<em>TOPIC='pageviews', VALUE</em>FORMAT='JSON');即可定义一个流,随后便可使用SQL进行过滤、聚合等操作。

四、实战场景与运维监控

- 典型应用场景:

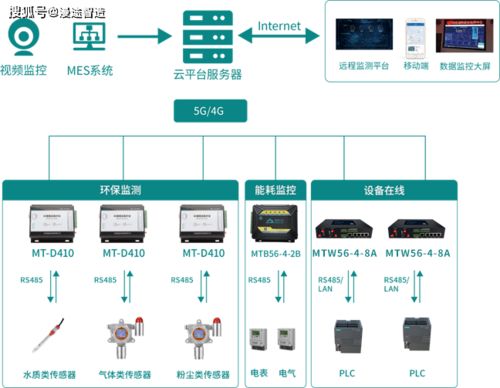

- 实时监控与报警:将应用日志、系统指标发送至Kafka,由下游消费者实时分析并触发报警。

- 用户活动追踪:网站或APP的用户点击流实时接入Kafka,用于实时推荐、个性化体验或欺诈检测。

- 微服务间通信:作为后端服务的事件总线,解耦服务,实现最终一致性。

- 数据湖/仓的实时摄入:作为传统批处理ETL的补充,将实时数据流持续注入数据湖(如Iceberg/Hudi)或数据仓库。

- 运维与监控:

- 关键指标:密切关注集群吞吐量(生产/消费)、请求延迟、网络流量、磁盘使用率、控制器(Controller)状态以及副本同步滞后(ISR)情况。

- 工具:利用Kafka自带的

kafka-topics.sh、kafka-consumer-groups.sh等脚本进行日常管理。集成JMX监控,并使用Prometheus+Grafana或Confluent Control Center等工具进行可视化监控和告警。

###

掌握Kafka实战,意味着您不仅能够搭建一个高性能的数据管道,更能构建起一个响应迅捷、洞察深刻的实时数据处理系统。从核心概念理解,到生产环境调优,再到利用Kafka生态进行流式计算,每一步都需要结合具体业务需求进行权衡和设计。随着技术的演进,Kafka正在与云原生、Serverless等趋势深度融合,持续巩固其作为实时数据流处理基石的领导地位。开始您的Kafka实战之旅,让数据流动起来,创造即时价值。